|

Artículos

Francisco Leslie López del Castillo Wilderbeek1

1 ![]() 0000-0002-6664-7849. Universitat Pompeu Fabra, España.

0000-0002-6664-7849. Universitat Pompeu Fabra, España.

![]() franciscoleslie@alumni.upf.edu

franciscoleslie@alumni.upf.edu

Recibido: 04/08/2023

Aceptado por pares: 25/01/2024

Enviado a pares: 25/09/2023

Aprobado: 30/01/2024

Para citar este artículo / to reference this article / para citar este artigo: López del Castillo, F. L. (2024). Inteligencia artificial generativa: determinismo tecnológico o artefacto construido socialmente. Palabra Clave, 27(1), e2719. https://doi.org/10.5294/pacla.2024.27.1.9

Resumen

El presente artículo analiza la inteligencia artificial generativa aplicando el modelo de construcción social de la tecnología, con el cual se observan los actores sociales afectados por esta tecnología con influencia para decidir su futuro. Los resultados obtenidos señalan que el éxito de la inteligencia artificial generativa no tiene un origen neutral, sino que está condicionado por los intereses de diferentes actores sociales. Este resultado, sin embargo, también indica que esta tecnología se encuentra en una fase de flexibilidad interpretativa. Es decir, que los grupos afectados por esta tecnología todavía están decidiendo su postura sobre la inteligencia artificial generativa y cómo podría ser en un futuro.

Palabras clave (Fuente tesauro de la Unesco): Construcción social de la tecnología; determinismo tecnológico; GenIA; inteligencia artificial generativa; SCOT.

Abstract

This article discusses generative artificial intelligence (GenAI) using the social construction of technology (SCOT) model, observing the social actors affected by this technology with influence to decide their future. The results indicate that the success of GenAI does not have a neutral origin but is conditioned by the interests of various social actors. However, it also suggests that this technology is in a phase of interpretive flexibility; that is, the affected groups are still deciding their position on GenAI and what it could be like.

Keywords: Social construction of technology; technological determinism; GenAI; generative artificial intelligence; SCOT.

Resumo

Neste artigo, é analisada a inteligência artificial generativa aplicando o modelo de construção social da tecnologia, que analisa os atores sociais afetados por essa tecnologia com influência na decisão de seu futuro. Os resultados indicam que o sucesso da inteligência artificial generativa não tem uma origem neutra, mas é condicionado pelos interesses de diferentes atores sociais. Esse resultado, entretanto, também indica que essa tecnologia está em uma fase de flexibilidade interpretativa. Ou seja, os grupos afetados por essa tecnologia ainda estão decidindo sua posição sobre a inteligência artificial generativa e como ela poderá ser no futuro.

Palavras-chave: Construção social da tecnologia; determinismo tecnológico; inteligência artificial generativa; GenIA; SCOT.

La inteligencia artificial generativa (GenIA) representa un fenómeno disruptivo que no solo proyecta incertidumbre respecto el futuro, sino que ya está impactando decisivamente en la sociedad. Como señala Tasioulas (2023, p. 1), actualmente se está produciendo una verdadera explosión de "esperanzas, sueños y fantasías sobre el potencial de las tecnologías basadas en la inteligencia artificial IA (por su acrónimo en inglés) para lograr avances sin precedentes en la realización de nuestros intereses personales y colectivos". Una cuestión fundamental de esta tecnología es su capacidad para crear contenidos, como texto, imágenes e incluso código de programación, con base en conocimiento precedente y habiendo recibido solo unas pocas indicaciones. Esta característica: la producción de contenido potencialmente nuevo, es crucial, ya que el resultado obtenido ofrece altos niveles de realismo y complejidad e incluso llega a emular la obra de un ser humano.

Así pues, este avance es, en el sentido más amplio, una virtual expansión de los sentidos, la conciencia y la capacidad de creación humana (McLuhan, 1964). Ante este contexto, la ecología de medios, como metadisciplina dedicada a los entornos mediáticos y a las interacciones con la tecnología (Strate, 1999), puede ofrecer respuestas, ya que en la IA generativa la computadora pasa a ser un sujeto activo, más que una herramienta de mediación (Gunkel, 2012), con lo cual cumple los pronósticos de Postman (2011), según los cuales la tecnología tiene el poder de determinar la existencia de la cultura.

Las implicaciones del uso de la IA generativa (GenAI) suponen un cambio radical en una gran variedad de campos (Kalla y Smith, 2023). La historia ha mostrado la alternancia de periodos de desarrollo y de crecimiento de la investigación en IA (llamados "primaveras"), con fases de decaimiento en interés y financiación ("inviernos' ') (Edwards, 1996; Delipetrev et al., 2020; Jiang et al., 2022). Sin embargo, se duda a la hora de explicar por qué una tecnología presuntamente tan poderosa como esta ha explotado en estos momentos con un impulso que parece no tener límites.

La pregunta principal que propone esta investigación parte de entender por qué la IA generativa ha alcanzado tan altas cotas de relevancia en tan poco tiempo. Si el reconocimiento que posee se encuentra vinculado a un mero determinismo tecnológico (los nuevos artefactos aparecen de forma independiente a la sociedad) o, por el contrario, si el advenimiento de la IA generativa es resultado de la presión ejercida por varios actores sociales.

Para encontrar respuesta a estas cuestiones, este trabajo ha aplicado el modelo de construcción social de la tecnología (Social Construction of Technology - SCOT; Pinch y Bijker, 1984). Esta forma de análisis de un artefacto o tecnología se basa en estudiar cómo los diferentes grupos sociales relacionados con un objeto sacan diversas interpretaciones acerca de este que acaban influyendo en el objeto, hasta que alcanza una forma y uso consensuado dentro de una sociedad. Como ejemplo paradigmático, el biciclo de finales de siglo XIX fue evolucionando debido a las presiones de los actores involucrados: usuarios, reguladores, fabricantes..., hasta llegar a ser la bicicleta contemporánea.

Para realizar este análisis se han tenido en cuenta los grupos sociales relevantes (GSR) con capacidad de influencia en el desarrollo de una tecnología. En esta lista, exhaustiva pero no cerrada, estarían los desarrolladores, las empresas productoras, los inversores, los poderes públicos (nacionales y supranacionales), las organizaciones empresariales y los trabajadores afectados por la GenIA. De la misma forma, para evaluar la capacidad de los GSR para determinar la forma de un artefacto es requisito conocer su posición y poder relativos en la estructura social (Klein y Kleinman, 2002).

El análisis de estos dos elementos (GSR y ponderación de estos) ha permitido alcanzar el objetivo de este trabajo: comprender si el éxito reciente de la IA generativa es un ejemplo de determinismo tecnológico inevitable en el que la ciencia avanza de forma independiente a la voluntad humana o, por el contrario, es un fenómeno construido socialmente. Esta cuestión posee una importancia capital para poder situar la IA generativa en el contexto de la ecología de medios como un nuevo escenario de interacción tecnológica entre hombre y máquina.

Metodología

Para cumplir con el objetivo citado anteriormente, este trabajo ha analizado los grupos sociales relevantes o GSR y su relevancia e influencia como actores significativos en el uso, interpretación y consideración de un artefacto tecnológico como la IA generativa. La metodología aplicada ha seguido el programa del modelo SCOT propuesto por Pinch y Bijker (1984), que ha demostrado su efectividad en el análisis y comprensión de diferentes artefactos y tecnologías, como la bicicleta o el cine (López del Castillo, 2022).

Las fases enunciadas por este modelo incluyen la determinación y análisis de los grupos sociales relevantes con respecto un artefacto, con capacidad de influir en su desarrollo; la demostración de la flexibilidad interpretativa de la nueva tecnología, pues cada grupo puede tener una visión diferente sobre la naturaleza y usos del artefacto; la evaluación de cómo y cuándo desaparece la flexibilidad interpretativa sobre el aparato; y, finalmente, la contextualización de estos procesos en el panorama social y político coetáneo. Junto con esta propuesta, conviene reseñar que, tal como alertan Klein y Kleinman (2002), no todos los grupos sociales relevantes poseen la misma influencia y esta depende de su posición social, económica o política.

Resultados

IA: ¿generadora o resultado de las expectativas?

Una máxima relacionada con el progreso tecnológico sostiene que toda innovación tecnológica se encuentra inmersa en un ciclo en el que, en primer lugar, se produce un sobredimensionamiento de las expectativas relacionadas con ella; más tarde, una desilusión sobre sus verdaderas capacidades, y, finalmente, una recuperación de la confianza en el valor futuro de esta tecnología (Dedehayir y Steinert, 2016). Este fenómeno, conocido como ciclo de la exageración (hype cycle) fue propuesto por la consultora Gartner y coincide plenamente con los vaivenes a los que se ha visto sometida la inteligencia artificial, entendida como un fenómeno disruptivo en el presente y en el pasado cercano.

La inteligencia artificial ha sufrido, desde sus inicios, importantes oscilaciones en sus posibilidades reales, desde la percepción de que podía lograr casi cualquier cosa hasta un dimensionamiento razonable sobre sus verdaderas capacidades. Las fases en las que la percepción sobre la IA ha sido moderada se consideran como invierno de IA, una etapa en la que tanto la tecnología como las empresas y los medios de comunicación no se dejan llevar por una ola de exageraciones y llegan a un consenso sobre lo que la IA puede o no puede hacer realmente como tecnología (Floridi, 2019). En esos momentos, los medios de comunicación desplazan su foco hacia otros temas de moda, al igual que las inversiones disponibles.

El primer invierno de la IA se produjo en los años 60 del siglo XX, cuando las enormes predicciones sobre sus posibilidades se encontraron con la realidad expresada en dos informes oficiales. Como consecuencia, los gobiernos de Estados Unidos y Reino Unido redujeron ostensiblemente la financiación que estaban otorgando a las universidades para este campo (Toosi et al., 2021). Según la literatura académica, los inviernos de la IA más relevantes se produjeron a finales de los años setenta, ochenta y noventa (Floridi, 2020) y ahora mismo podríamos estar a las puertas de otro (Hirsch-Kreinsen, 2023; Nield, 2019; Walch, 2019; Schuchmann, 2019), lo que representa una oportunidad para cuestionarnos si la IA va a reemplazar realmente las soluciones ya existentes o va a diversificarlas, complementarlas y ampliarlas (Floridi, 2020).

Grupos sociales relevantes

Desarrolladores. En contraposición a las teorías de construcción social de la tecnología, las tesis deterministas sostienen que la tecnología es autónoma. Según este punto de vista, los avances técnicos no se encuentran empujados por intereses económicos o sociales. En el caso de la GenAI, aunque hay muchos servicios de IA disponibles gracias a la entrada de pequeñas empresas, son las grandes corporaciones tecnológicas, como Amazon, Google, IBM y Microsoft, las que se han centrado en la IA y la consideran un servicio más que pueden ofrecer (Sundberg y Holmstrõm, 2023). En este sentido, el reciente trabajo de Rikap (2023) concluyó que las grandes tecnológicas mantienen una posición hegemónica en la configuración, la vigilancia y el control de lo que se desarrolla en el campo de la inteligencia artificial. Esta posición de dominio expresada en concentración de poder e influencia daría lugar a una competencia sesgada, una innovación limitada y un acceso restringido al mercado para otros actores o grupos minoritarios (Wach et al., 2023). Una situación que, según Niyazov (2019), ya está en marcha y es difícil de detener: la formación de monopolios de inteligencia artificial. Por este motivo ya se considera que la regulación del mercado de la IA es necesaria para, entre otras cosas, garantizar la igualdad de condiciones, promover la competencia leal y evitar posibles riesgos geopolíticos (Wach et al., 2023).

Inversores. Como se ha indicado anteriormente, las fuentes de financiación son determinantes para impulsar la investigación en IA y lograr los objetivos que se considera que es capaz de alcanzar, en una potencial paradoja de profecía autocumplida. Los beneficios económicos atribuibles a la IA podrían representar un aumento del 7% del PIB mundial (unos USD $7 billones de dólares), con un crecimiento de la productividad del 1,5% en 10 años según el banco de inversión Goldman Sachs (2023). Según la consultora McKinsey (2023), los sectores que mejorarán sus ingresos por la IA son la banca, la alta tecnología y las ciencias de la vida. Estas predicciones representan una invitación a la movilización de capitales en IA para la obtención de beneficios; sin embargo, recientemente el mercado de inversiones ha vivido ciclos de exageración en el sector de la tecnología, como el Blockchain o el metaverso (Slowinski y Pearson, 2023). En este contexto, los fondos de capital riesgo (venture capital) han jugado un papel fundamental, al ser organizaciones dedicadas a la inversión colectiva que financian empresas de nuevo cuño y con elevado potencial de crecimiento, a la espera de obtener un retorno rápido.

Tal como señala Global Data (2023), más de una docena de compañías emergentes de GenAI se han visto catapultadas por la inversión de capital riesgo y han alcanzado el estatus de "unicornio" -empresa creada hace menos de diez años que, pese a no cotizar en bolsa ni haber sido comprada por otra, logra un valor de USD $1.000 millones de dólares o superior nivel mundial- en solo tres o cuatro años, cuando la norma típica de los unicornios está entre los siete y nueve años. Por tanto, los inversores de capital riesgo han reducido a la mitad el tiempo en el que una pequeña empresa de GenAI alcanza la mágica cifra de USD $1.000 millones de dólares. La duda en este caso es si se están sobreestimando las "promesas y potencialidades" de este nuevo modelo, pues esa es la raíz de la generación de burbujas especulativas, con incremento injustificado del precio de un activo o producto, en la innovación tecnológica (Goldfarb y Kirsch, 2019).

Por otro lado, el trabajo de Lyonnet y Stern (2022) dedujo algorítmicamente que las decisiones de inversión de los fondos de capital riesgo en tecnología son atribuibles a las características de los fundadores (sexo, edad y educación), más que a la verdadera evaluación objetiva del rendimiento futuro de las empresas en las que invierten. De la misma forma, esta subjetividad inherente se encuentra conectada con la pretensión de unos retornos en el corto plazo. Como afirman Lerner y Nanda (2020), cuando el capital de riesgo invierte en innovación se marca un periodo cerrado (normalmente de diez años). Esta ventana acotada en el tiempo se considera que es suficiente para que la idea empresarial (como la GenAI) pueda comercializarse y dé una oportunidad de salida del capital de riesgo con beneficios. No obstante, las condiciones del mercado pueden acelerar todavía más la desinversión de los fondos (como sucedió en las crisis de los años 2000, 2008 y 2020) y hacer que no puedan cristalizar las verdaderas oportunidades de la idea tecnológica en la que se está trabajando. Un escenario de estas características supondría, en el caso de la GenAI, la formación de un nuevo invierno.

Empleadores. Según la opinión de Vinsel (2023), a medida que se entra en un periodo de incertidumbre económica las direcciones de las compañías se plantean dónde invertir más, pero también dónde recortar gastos con la AI. La valoración de la Unión Europea en 2020 (Europ ean Parliament, 2020) pronosticaba que el 14% de los empleos en los países de la Organización para la Cooperación y el Desarrollo Económico (OCDE) eran susceptibles de ser automatizados por la IA y, su vez, un 32% podrían sufrir cambios sustanciales. En las mismas fechas, el Foro Económico Mundial (WEF, 2020) puso como cifra que 85 millones de puestos de trabajo serían reemplazados por la IA en todo el mundo entre 2020 y 2025.

La literatura previa sostiene que los problemas económicos de las empresas son la principal causa de despidos masivos, al ocasionar un 4% de estos (Abbring et al., 2002). Por el contrario, los procesos de automatización serían menos traumáticos que los despidos masivos, al generar solo un 2% de despidos en el primer año de implantación de un proceso automático1 (Bessen et al., 2020). Estos datos se vuelven obsoletos con la generalización de uso de la GenAI. Según Goldman Sachs (2023), la GenAI permite automatizar en mayor o menor medida dos tercios de los actuales empleos que existen en Estados Unidos. Estas premoniciones han empezado a cristalizar en 2023: British Telecom anunció la sustitución de 10.000 puestos de trabajo por la GenAI, esto es, un 7,7% de su plantilla (Sweney, 2023). Lo mismo ocurrió con IBM, que espera reemplazar 7.800 empleos, un 3% de su plantilla (Ghoshal, 2023). Según la consultora Challenger, Gray & Christmas, la inteligencia artificial provocó el 5% de los recortes de empleo en el mes de mayo de 2023 en Estados Unidos; en concreto, fueron 417.500 personas (Shin, 2023).

Trabajadores. Se ha citado anteriormente cómo las empresas están usando la GenAI como herramienta de reducción de costes (automatización de masa laboral). La cuestión es cómo esa situación impacta en las personas, tanto a las todavía empleadas como a aquellas afectadas por el reemplazo. Por un lado, las predicciones sostienen que se producirá una generación de nuevos puestos de trabajo relacionados con la GenAi (Oxford Analytica, 2023); por ejemplo, la consultora McKinsey valora que habrá un aumento del 23% en la demanda de puestos de trabajo relacionados con la ciencia y la tecnología, ya que las empresas se encuentran en un proceso de introducción de sus lógicas de producción a la IA. Por otro lado, habrá una importante reformulación de las tareas e incluso de las ocupaciones desempeñadas. En el primer caso, la GenAI asumirá tareas rutinarias y repetitivas (Oxford Analytica, 2023); en el segundo, los cálculos de la consultora de McKinsey (2023) indican que 12 millones de personas cambiarán de carrera profesional para 2030, un 25% más de lo que se había evaluado anteriormente.

Además de esto, según los datos históricos, se considera que los trabajadores de las empresas en los que se aplican procesos de automatización y que mantienen el empleo sufren una reducción media del 11% del salario (Bessen et al., 2020). Pero ¿en qué posición quedarían los trabajadores supervivientes, además de verse afectados en el aspecto salarial? Según los estudios actuales, los empleados humanos supondrán el recurso de nivel superior cuando la AI no pueda implantarse completamente, o se instalará una versión de bajo coste de esta, cuando la mano de obra tenga un precio inferior respecto la IA (Orchard y Tasiemski, 2023). Por este motivo, en países como China, India y México, donde los sueldos son más bajos, los procesos de automatización tardarán más en incorporarse (McKinsey, 2023). En todo caso, las organizaciones en defensa de los trabajadores (sindicatos) deberían reformularse y asumir, entre otros roles, la capacitación de los trabajadores en aquellos sectores en los que la automatización no sustituye completamente a la mano de obra humana (Nissim y Simon, 2021).

Sobre el supuesto de que los trabajadores que perderán el empleo existe consenso en que las ocupaciones más amenazadas por el GenIA son las del mundo creativo de cuello blanco -profesionales con formación que normalmente realizan tareas administrativas-, ya que tienen un riesgo mucho mayor de afectación y despido (Chohan, 2023). En segundo orden estarían los trabajos del sector del conocimiento, incluso en aquellos cargos de alto nivel que hasta hace poco se consideraban inmunes a los procesos de automatización (McKinsey, 2023). Estas predicciones generan, a su vez, un sesgo de género, pues según el análisis de Ellingrud et al. (2023), las mujeres tendrían 1,5 veces más posibilidades de perder el empleo por la Gen-IA que los hombres.

La cuestión radicaría entonces en la situación de las personas que ya han perdido su empleo por la IA. En este sentido, la opinión Sam Altman, creador de ChatGPT, en un temprano 2021, expresaba que "a medida que la IA produzca la mayoría de los bienes y servicios básicos del mundo, las personas podrán pasar más tiempo" haciendo otras cosas y consumiendo gracias a una retribución anual del Estado. Esta perspectiva podría promover la idea de una Renta Básica Universal, un sistema de protección en que todos los ciudadanos de un país reciben un pago económico por contraprestación, ya que, como indica Ponce (2023, p. 2), "ningún mercado laboral puede resistir el poder transformador de la IA generativa [...] si persisten bolsas de desigualdad y precariedad". Ante este contexto, Liu y Peng (2022) sostienen que, debido al desempleo estructural por el uso masivo de la AI, se desarrollará un mayor esfuerzo por parte de los gobiernos para mejorar el sistema de seguridad social y reducir el riesgo de desempleo.

Gobiernos. La literatura académica (De Clément, 2022) concuerda en señalar que la naturaleza volátil y cambiante de la AI fuerza a que su regulación solo pueda basarse en principios generales de protección y resguardo. Esto es debido a que la AI puede poner en riesgo un amplio espectro de elementos, entre otros, los valores constitucionales fundamentales, la justicia social, la protección de la libertad de desarrollo económico, cultural y político y la prevención de la discriminación (Hoffmann-Riem, 2020).

Un elemento importante indicado por Black y Murray (2019) es que en la historia del desarrollo tecnológico los nuevos avances han pasado normalmente por uno de dos caminos: si la comercialización del nuevo artefacto ha requerido una aprobación o licencia antes de su comercialización o si, por el contrario, su regulación se ha producido cuando ya se encontraba en el mercado. Sin embargo, aunque algunas voces han pedido una pausa en su desarrollo (Bengio et al., 2023), la problemática en el caso de la IA es que esta ya no puede "devolverse a la caja" (Black y Murray, 2019, p. 14). Por esta razón el debate regulatorio a nivel nacional tanto como internacional ha sido sobre la ética de la AI (Hoffmann-Riem, 2020). Como ejemplo paradigmático está la Ley de la IA de la Unión Europea (Parlamento Europeo, 2023). Esta fue la primera ley en todo el mundo que intentó regular el uso y efectos de la inteligencia artificial. Sus objetivos fueron garantizar el "desarrollo de una inteligencia artificial segura, digna de confianza y ética" cumpliendo con unos estándares éticos. El funcionamiento de la ley se basa en un sistema de evaluación de riesgos, aunque algunos autores sostienen que esta perspectiva es demasiado limitada para enfrentarse a tecnologías de GenAI muy evolucionadas como Chat-GPT (Hacker et al., 2023; Helberger y Diakopoulos, 2023).

En todo caso, la Unión Europea reconoce que la IA (Ulnicane, 2022) lleva aparejada un conjunto de riesgos potenciales, como la opacidad en la toma de decisiones, la discriminación de distintos tipos, la intromisión en la vida privada o su uso delictivo. Sin embargo, a este respecto Tasioulas (2019) afirma que la aplicación de los principios éticos en el caso de la GenAI debe tener en cuenta la multiplicidad de niveles de interacción en los que surgen cuestiones éticas ligadas a esta tecnología, reconocer que afectan a toda la gama de valores humanos, en lugar de dar un listado cerrado de valores éticos o jurídicos, y que la aplicación práctica de la ética a la IA debe estar debidamente informada y hacerse de forma realista en cuanto a sus capacidades existentes y previsibles, en lugar de basarse en exageraciones promovidas por actores involucrados.

Por otro lado, algunas propuestas sostienen que la AI, más que confiable -perspectiva de la UE- debería ser sostenible, tanto en el uso de recursos como en el reconocimiento del interés colectivo de la sociedad en general (Hacker, 2023). Otros autores, como Erdelyi y Goldsmith (2018), proponen la creación de una organización internacional que sea capaz de encauzar y coordinar los esfuerzos políticos nacionales de aquellos Estados miembros.

Interpretación del artefacto

Como se ha comentado anteriormente, los grupos sociales relevantes (GSR) interactúan con los nuevos artefactos de manera que son capaces de decidir su futuro. Evidentemente estos actores sociales no se encuentran en igualdad de condiciones entre ellos, pero sí que pueden influir en mayor o menor medida. Un mismo artefacto/tecnología tiene diferentes interpretaciones, según el grupo social, ya que para cada uno de estos resuelve diferentes necesidades o problemas. Siguiendo el orden mencionado anteriormente, para los desarrolladores de la tecnología existe un interés en ofrecer la IA como un servicio más, de manera que las grandes empresas tecnológicas puedan mantener o extender su posición de dominio. En segundo orden estarían los inversores de capital riesgo, que son las organizaciones que están impulsando decisivamente la financiación de empresas dedicadas a la AI. Estos inversores se encuentran a la espera de retornos rápidos (10 años o menos), por lo que, si bien están propiciando el ciclo relacionado con la IA en el corto plazo, podrían generar un invierno de la IA, si la situación económica empeora.

Con respecto a las organizaciones empleadoras, la IA es una posibilidad de primer orden para abaratar costes gracias a la automatización. De esta forma, como se ha detallado con datos, el mercado de trabajo está ante la posibilidad de destruir un gran porcentaje de empleos, aunque sea necesaria la incorporación limitada de nuevos perfiles para la implantación de la IA. Como efecto secundario de la interpretación de las empresas -con la IA como forma de reducción de costes-, nos encontraríamos con un panorama laboral en el que los empleados que conservan su puesto de trabajo estarían en dos niveles diferentes. En un nivel superior estarían los empleados que han visto cualificadas sus funciones gracias a la IA y la usan de manera intensiva eliminando tareas repetitivas y con poco valor añadido. En este punto los sindicatos tendrían a la IA como una oportunidad para capacitar a la masa laboral. En un nivel inferior -e inicialmente en países con costes laborales más bajos- estarían los trabajadores en cuyas ocupaciones la AI no mejora la relación coste/beneficio, esto es, en tareas donde el salario sigue siendo inferior respecto del coste de implantación de la AI.

Otros afectados por la orientación de los empleadores serían los trabajadores que efectivamente han quedado fuera del mercado por la IA y que no han reformulado su perfil en línea con los nuevos empleos generados. En este segmento existen propuestas para la instauración de una renta personal basada en los beneficios económicos generados por la IA. A su vez, en este sentido, existe una discriminación de género, pues se considera que la IA tendrá más afectación en el empleo femenino, que no en el masculino, y ello abre nuevas preguntas sobre si el desarrollo de la IA es realmente neutral. Como ejemplo paradigmático de esta situación estaría la postura de Winner (1993), según la cual los puentes para acceder a Long Island se construyeron de forma que no permitieran el paso a los autobuses en los que viajaba la clase obrera. Por tanto, la GenIA podría estar impulsada inconscientemente por un sesgo de género.

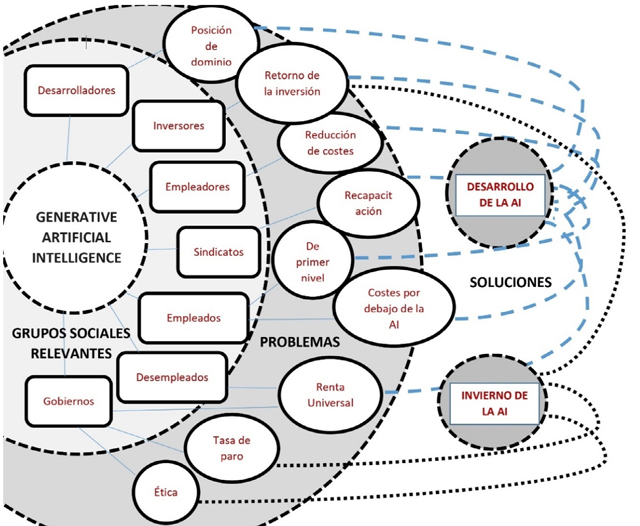

Finalmente, los gobiernos interpretan la IA desde dos perspectivas. Por un lado, la de garantizar que su uso sea ético. En este supuesto, es una verdadera amenaza que la tecnología -todavía en desarrollo- avance más rápido que la capacidad para evaluar sus consecuencias. Por otro, los efectos en el mercado laboral suponen una amenaza para los gobiernos, ya que los obliga a reforzar sus políticas de seguridad social o incluso la instauración de una renta universal. Este conjunto de interpretaciones, problemas y posibles soluciones se puede captar detalladamente en la Figura 1.

Figura 1. Relaciones entre GenIA y GSR*

* Según el modelo de Pinch y Bijker (1984) en una estructura de círculos concéntricos.

Fuente: elaboración propia.

Conclusiones

Este trabajo analiza el advenimiento de la inteligencia artificial generativa (GenIA) como artefacto que está impactando en el ecosistema tecnológico y en la misma sociedad. Este análisis se ha llevado a cabo según el modelo SCOT de construcción social de la tecnología, de Pinch y Bijker (1984).

Una vez observadas todas las interpretaciones y relaciones entre los grupos sociales relevantes y la inteligencia artificial generativa, como artefacto tecnológico, no puede afirmarse que la GenAI tenga su origen en la neutralidad tecnológica. Más bien, al contrario, existen intereses claros para que esta tecnología prospere, presiones que indican que la GenAI es un artefacto construido socialmente.

Por una parte, los grandes desarrolladores ven la GenAI como una manera de fortalecer su posición de dominio, al incorporarla como servicio. En la misma línea de interpretación, las empresas empleadoras consideran esta tecnología como una perfecta forma de abaratar costes en términos de mano de obra. Esta interpretación, que ya está manifestándose, lleva a otro conjunto de interpretaciones, en este caso como problemas potenciales. Por un lado, los empleados en activo necesitan adaptarse al nuevo modelo y, por otro, una gran masa laboral está condenada al desempleo. La interpretación en este caso es más de amenaza que de oportunidad.

Y este no es únicamente un problema para los trabajadores, entendidos individualmente, sino que termina afectando a los gobiernos y reguladores. La mano de obra expulsada del mercado se encuentra dentro de la esfera de la responsabilidad de los gobiernos, cuya interpretación de la GenIA difiere respecto desarrolladores y empleadores. De la misma forma, la ética en su uso es una cuestión acuciante para los gobiernos, tal como lo ha reconocido la UE, y de difícil solución, por el desarrollo constante y en curso. Finalmente se encuentran los inversores, como palancas del crecimiento de la IA. Estos tienen una interpretación dual: en el corto plazo ven la tecnología como una forma de retorno de la inversión. Sin embargo, de sobrevenir una situación económica adversa, ello podría acelerar las desinversiones en este campo, como ha ocurrido en situaciones anteriores.

Estas múltiples interpretaciones confirman que todavía nos encontramos en la fase de flexibilidad interpretativa enunciada por el modelo SCOT, según la cual una misma tecnología es considerada de diferentes formas por cada grupo social involucrado. Las presiones ejercidas por estos actores (por ejemplo, los gobiernos y sus preocupaciones éticas), junto con la posición y poder relativos de estos en la estructura social (por ejemplo, las grandes corporaciones tecnológicas) (Klein y Kleinman, 2002) serán determinantes para configurar el rol y uso que tendrá la inteligencia general generativa en nuestra sociedad.

De la misma forma se abren nuevos interrogantes, pues si las previsiones sobre empleo destruido por la GenIA se cumplen, la masa laboral femenina se verá fuertemente perjudicada (50% más de despidos que en los hombres) y ello erradica completamente la idea de que el desarrollo de esta tecnología es completamente neutral y plantea dudas respecto de un determinismo social antes que tecnológico.

Notas

1 El perfeccionamiento de la automatización generaría despidos posteriores, pero con menor impacto.

Referencias

Abbring, J., Van den Berg, G., Gautier, P., Van Lomwel, A., Van Ours, J. y Ruhm, C. (2002). Displaced workers in The United States and The Netherlands. En Kuhn, P. (ed.), Losing work, moving on: international perspectives on worker displacement. W.E. Upjohn Institute. https://doi.org/10.17848/9781417505333.Ch2

Altman, S. (2021). Moore's Law for Everything. 16 de marzo. https://moores.samaltman.com/

Bengio, Y., Russell, S., Musk, E. y Wozniak, S. (2023). Pause giant AI experiments: An open letter. Future of Life Institute.

Black, J. y Murray, A. D. (2019). Regulating AI and machine learning: Setting the regulatory agenda. European Journal of Law and Technology, 10(3). https://www.ejlt.org/index.php/ejlt/article/view/722

Bessen, J., Goos, M., Salomons, A. y Van den Berge, W. (2020). Automation: A guide for policymakers. Economic Studies at Brookings Institution.

Budhwar, P., Chowdhury, S., Wood, G., Aguinis, H., Bamber, G. J., Beltran, J. R., y Varma, A. (2023). Human resource management in the age of generative artificial intelligence: Perspectives and research directions on ChatGPT. Human Resource Management Journal, 33(3), 606-659. https://doi.org/10.1111/1748-8583.12524

Chohan, U. W. (2023). Generative AI, ChatGPT, and the Future ofJobs. SSRN, 28 de abril. https://doi.org/10.2139/ssrn.4411068

De Clément, Z. D. (2022). Inteligencia artificial en el derecho internacional, Naciones Unidas y Unión Europea. Revista Estudios Jurídicos, 22. https://doi.org/10.17561/rej.n22.7524

Dedehayir, O. y Steinert, M. (2016). The hype cycle model: A review and future directions. Technological Forecasting and Social Change, 108, 28-41. https://doi.org/10.1016/j.techfore.2016.04.005

Delipetrev, B., Tsinaraki, C. y Kostic, U. (2020). Historical evolution of artificial intelligence. Analysis of the three main paradigm shifts in AI. European Union. https://doi.org/10.2760/801580

Edwards, P.N. (1996). The closed world: computers and the politics of discourse in Cold War America. MIT Press. https://doi.org/10.7551/mitpress/1871.001.0001

Erdelyi, O. J. y Goldsmith, J. G. (2018). Regulating artificial intelligence: Proposal for a global solution. En AAAI/ACM Conference on Artificial Intelligence, Ethics and Society, New Orleans, 1-3 de febrero. https://doi.org/10.1145/3278721.3278731

European Parliament (2020). Artificial intelligence: Threats and opportunities. 23 de septiembre. https://www.europarl.europa.eu/news/en/headlines/society/20200918STO87404/artificial-intelligence-threats-and-opportunities

Floridi, L. (2020). AI and its new winter: From myths to realities. Philosophy & Technology, 33, 1-3. https://doi.org/10.2139/ssrn.3830584

Floridi, L. (2019). What the near future of artificial intelligence could be. Philosophy & Technology, 32(1), 1-15. https://doi.org/10.1007/s13347-019-00345-y

Global Data (2023). GenAI startups rewrite unicorn playbook: Race to billion-dollar valuations in record time, reveals Global Data. 25 de mayo. https://www.globaldata.com/media/disruptor/genai-startups-rewrite-unicorn-playbook-race-to-billion-dollar-valuations-in-record-time-reveals-globaldata/

Goldman Sachs (2023). Generative AI could raise global GDP by 7%. 5 de abril. https://www.goldmansachs.com/intelligence/pages/generative-ai-could-raise-global-gdp-by-7-percent.html

Ellingrud, W, Sanghvi, S., Singh Dandona, G., Madgavkar, A., Chui, M., White, O. y Hasebe (2023). Generative AI and the future of work in America. McKinsey, 26 de julio. https://www.mckinsey.com/mgi/our-research/generative-ai-and-the-future-of-work-in-america-/

Goldfarb, B. y Kirsch, D. A. (2019). Bubbles and crashes: The boom and bust of technological innovation. Stanford University Press. https://doi.org/10.1515/9781503607934

Ghoshal, A. (2023). Job cuts may intensify as IBM plans to use AI to replace 30% of back office jobs. Computer World, 2 de mayo. https://www.computerworld.com/article/3694874/job-cuts-may-intensify-as-ibm-plans-to-use-ai-to-replace-30-of-back-office-jobs.html

Gunkel, D. J. (2012). Communication and artificial intelligence: Opportunities and challenges for the 21st century. Futures of Communication, 1(1). https://doi.org/10.7275/R5QJ7F7R

Hacker, P. (2023). Sustainable AI regulation. SSRN, 1 de junio. https://doi.org/10.2139/ssrn.4467684

Hacker, P., Engel, A. y Mauer, M. (2023). Regulating ChatGPT and other large generative AI models. En Proceedings of the 2023 ACM Conference on Fairness, Accountability, and Transparency (pp. 1112-1123). ACM DL. https://doi.org/10.1145/3593013.3594067

Helberger, N. y Diakopoulos, N. (2023). ChatGPT and the AI Act. Internet Policy Review, 12(1). https://doi.org/10.14763/2023.1.1682

Hirsch-Kreinsen, H. (2023). Artificial intelligence: A "promising technology". AI & Society, 1-12. https://doi.org/10.1007/s00146-023-01629-w

Hoffmann-Riem, W. (2020). Artificial intelligence as a challenge for law and regulation. Regulating Artificial Intelligence, 1-29. https://doi.org/10.1007/978-3-030-32361-5_1

Jiang, Y., Li, X., Luo, H., Yin, S. y Kaynak, O. (2022). Quo vadis artificial intelligence? Discover Artificial Intelligence, 2(1), 4. https://doi.org/10.1155/2010/629869

Kalla, D. y Smith, N. (2023). Study and analysis of Chat GPT and its impact on different fields of study. International Journal of Innovative Science and Research Technology, 8(3). https://papers.ssrn.com/sol3/papers.cfm?abstract_id=4402499

Klein, H. K. y Kleinman, D. L. (2002). The social construction of technology: Structural considerations. Science, Technology y Human Values, 27(1), 28-52. https://doi.org/10.1177/016224390202700102

Lerner, J. y Nanda, R. (2020). Venture capital's role in financing innovation: What we know and how much we still need to learn. Journal of Economic Perspectives, 34(3), 237-261. https://doi.org/10.3386/w27492

Liu, Z. Z. y Peng, S. L. (2022). A study on the optimization path ofArtificial Intelligence governance in the public policy perspective. En International Conference on Public Organization (Iconpo 2021) (pp. 97-103). Atlantis Press.

Lyonnet, V. y Stern, L. H. (2022). Venture capital (mis) allocation in the age of AI. En Proceedings of the Eurofidai-ESSEC Paris December Finance Meeting2022. SSRN. https://doi.org/10.2139/ssrn.4260882

McKinsey (2023). The economic potential of generative AI: The next productivity frontier. 14 de junio. https://www.mckinsey.com/capabilities/mckinsey-digital/our-insights/the-economic-potential-of-generative-ai-the-next-productivity-frontier

McLuhan, M. (1964). Understanding media: The extensions of man. McGraw-Hill

Nield, T. (2019). Is deep learning already hitting its limitations? And is another AI winter coming? Towards Data Science. https://towardsdatascience.com/is-deep-learning-already-hitting-its-limitations-c81826082ac3

Nissim, G. y Simon, T. (2021). The future of labor unions in the age of automation and at the dawn of AI. Technology in Society, 67, 101732. https://doi.org/10.1016/j.techsoc.2021.101732

Niyazov, S. (2019). AI-powered monopolies and the New World Order. Towards Data Science, 28 de junio. https://towardsdatascience.com/ai-powered-monopolies-and-the-new-world-order-1c56cfc76e7d

Orchard, T. y Tasiemski, L. (2023). The rise of generative AI and possible effects on the economy. Economics and Business Review, 9(2). https://doi.org/10.18559/ebr.2023.2.732

Oxford Analytica (2023). GenAI could boost global economic productivity. Oxford Analytica Daily Brief. https://dailybrief.oxan.com/Analysis/DB279010/GenAI-could-boost-global-economic-productivity

Parlamento Europeo (2023). Ley de IA de la UE: primera normativa sobre inteligencia artificial. https://www.europarl.europa.eu/topics/es/article/20230601STO93804/ley-de-ia-de-la-ue-primera-normativa-sobre-inteligencia-artificial

Pinch, T. J. y Bijker, W. E. (1984). The social construction of facts and artefacts: Or how the sociology of science and the sociology of technology might benefit each other. Social Studies of Science, 14(3), 399-441. https://doi.org/10.1177/030631284014003004

Ponce del Castillo, A. (2023). Generative AI, generating precariousness for workers? AI & Society, 1-2. https://doi.org/10.1007/s00146-023-01719-9

Postman, N. (2011). Technopoly: The surrender of culture to technology. Random House.

Rikap, C. (2023). Same end by different means: Google, Amazon, Microsoft and Facebook's strategies to dominate artificial intelligence. SSRN. https://doi.org/10.2139/ssrn.4472222

Schuchmann, S. (2019). Probability ofan approaching AI winter. Towards Data Science, 17 de agosto. https://towardsdatascience.com/probability-of-an-approaching-ai-winter-c2d818fb338a

Strate, L. (1999). The varieties of cyberspace: Problems in definition and delimitation. Western Journal of Communication, 63(3), 382-412. https://doi.org/10.1080/10570319909374648

Shin, R. (2023) The A.I. job culling has already begun and 4,000 people lost work last month to the technology, according to a new report. Fortune, 2 de junio. https://fortune.com/2023/06/02/ai-job-cuts-layoffs-tech-industry-challenger-grey/

Slowinski, S. y Pearson, S. (2023) GenAI: a revolution across all sectors? BNP Paribas, 3 de julio. https://globalmarkets.cib.bnpparibas/genai-a-revolution-across-all-sectors/

Sundberg, L. y Holmstrõm, J. (2023). Democratizing artificial intelligence: How no-code AI can leverage machine learning operations. Business Horizons, 66(6), 777-788. https://doi.org/10.1016/j.bushor.2023.04.003

Sweney, M. (2023). BT to axe up to 55,000 jobs by 2030 as it pushes into AI. The Guardian, 18 de mayo. https://www.theguardian.com/business/2023/may/18/bt-cut-jobs-telecoms-group-workforce

Tasioulas,J. (2019). First steps towards an ethics of robots and artificial intelligence. Journal of Practical Ethics, 7(1). https://doi.org/10.2139/ssrn.3172840

Tasioulas, J. (2023). The rule of algorithm and the rule of law. Vienna Lectures on Legal Philosophy. https://doi.org/10.2139/ssrn.4319969

Toosi, A., Bottino, A. G., Saboury, B., Siegel, E. y Rahmim, A. (2021). A brief history of AI: how to prevent another winter (a critical review). PET Clinics, 16(4), 449-469. https://doi.org/10.1016/j.cpet.2021.07.001

Ulnicane, I. (2022). Artificial intelligence in the European Union: Policy, ethics and regulation. En The Routledge Handbook of European Integrations. Taylor & Francis. https://doi.org/10.4324/9780429262081-19

Vinsel, L. (2023). Don't get distracted by the hype around generative AI. MIT Sloan Management Review, 64(3), 1-3. https://sloanreview.mit.edu/article/dont-get-distracted-by-the-hype-around-generative-ai/

Wach, K., Duong, C. D., Ejdys, J., Kazlauskaité, R., Korzynski, P., Mazurek, G., ... y Ziemba, E. (2023). The dark side of generative artificial intelligence: A critical analysis ofcontroversies and risks of Chat GPT. Entrepreneurial Business & Economics Review, 11 (2). https://doi.org/10.15678/EBER.2023.110201

Walch, K. (2019). Are we heading for another AI winter soon? Forbes. https://www.forbes.com/sites/cognitiveworld/2019/10/20/are-we-heading-for-another-ai-winter-soon/-783bf81256d6

Winner, L. (1993). Social constructivism: Opening the black box and finding it empty. Science as Culture, 3(3), 427-452. https://doi.org/10.1080/09505439309526358

WEF - World Economic Forum (2020). The Future of Jobs Report. Octubre. https://www3.weforum.org/docs/WEF_Future_of_Jobs_2020.pdf